Firecrawl 개요

Firecrawl은 AI 기반의 오픈소스 웹 스크래핑 및 크롤링 플랫폼으로, 웹사이트를 LLM(대형 언어 모델)에 적합한 데이터 형식(예: Markdown, JSON, 구조화된 데이터)으로 변환해줍니다. JavaScript 기반의 동적 웹페이지도 자동으로 수집할 수 있어 개발자, 데이터 과학자, AI 연구자들에게 유용한 도구입니다.

🔧 주요 기능

- Scrape:

단일 URL의 콘텐츠를 Markdown, HTML, 구조화된 JSON, 스크린샷으로 추출합니다.

→ 기능 문서 보기 - Crawl:

사이트맵 없이도 모든 하위 페이지를 탐색하고, LLM에 최적화된 데이터를 제공합니다.

→ 기능 문서 보기 - Map:

웹사이트 내 모든 URL을 빠르게 수집합니다. - Search:

웹 검색을 수행하고 검색 결과에서 전체 콘텐츠를 추출합니다. - Extract:

자연어 프롬프트를 이용해 웹 페이지에서 구조화된 데이터를 자동 추출합니다.

→ 기능 소개 - 고급 기능:

- JavaScript 렌더링 페이지 등 동적 콘텐츠 처리 가능

- 프록시, 요청 제한, 안티-봇 우회 기능 탑재

- PDF, DOCX, 이미지 등 미디어 파싱 가능

- 클릭, 스크롤, 입력 등의 인터랙션 처리 지원

→ 전체 문서 보기

🧰 연동 및 SDK

- SDK 지원 언어: Python, Node.js, Go, Rust

- 연동 가능한 플랫폼: LangChain, LlamaIndex, Crew.ai

- 로우코드 툴: Dify, Langflow, Flowise

- 자동화 툴: Zapier, Pabbly Connect 지원

🚀 시작하기

- 무료 크레딧 500개 제공, 신용카드 불필요

- firecrawl.dev 에서 API 키 발급

- 인터랙티브 플레이그라운드로 기능 테스트 가능

- 셀프 호스팅 가이드 제공

🧠 활용 예시

- AI 학습 데이터 구축: 대규모 고품질 텍스트 수집

- 시장 조사: 경쟁사 및 트렌드 분석

- 리드 발굴: 잠재 고객 정보 자동 수집

- 콘텐츠 통합: 뉴스, 리서치 자료 수집

시연 영상 보기

AI Web Scraper for LLM-Ready Data - Firecrawl

Firecrawl은 단순한 웹 스크래퍼 수준을 넘어서 AI 친화적인 웹 데이터 수집 자동화 플랫폼입니다. 각 기능이 실제로 어떤 식으로 웹 스크래핑에 유용한지 자세히 설명드릴게요:

1. Scrape (단일 페이지 스크래핑)

- 무엇을 할 수 있나?

단일 URL의 웹페이지를 크롤링해 다음과 같은 형태로 출력:- Markdown

- HTML

- 구조화된 JSON (LLM 훈련에 적합)

- 스크린샷

- 유용한 이유

프론트엔드가 복잡하거나 자바스크립트 기반 SPA(Single Page Application)라 하더라도 실제 유저가 보는 뷰를 기준으로 데이터를 추출할 수 있음.

2. Crawl (사이트 전체 크롤링)

- 무엇을 할 수 있나?

사이트맵 없이도 특정 URL을 시작점으로 모든 하위 링크를 자동 탐색하며 콘텐츠 수집. - 유용한 이유

제품 상세 페이지, 블로그 포스트, 뉴스 기사처럼 수백~수천 개의 페이지를 자동으로 크롤링하고 LLM 학습용으로 정제된 데이터를 확보할 수 있음.

3. Map (URL 지도 생성)

- 무엇을 할 수 있나?

입력한 도메인 내의 모든 페이지 URL 리스트를 추출. - 유용한 이유

대규모 사이트에서 "어떤 페이지가 있는지" 먼저 파악하고 전략적으로 필요한 페이지만 스크래핑할 수 있음.

4. Search (웹 검색 + 내용 추출)

- 무엇을 할 수 있나?

구글이나 Bing 검색처럼 키워드 기반으로 관련 웹페이지를 찾고, 해당 페이지의 본문 콘텐츠를 자동 수집. - 유용한 이유

주제 기반 크롤링이 가능하며 뉴스/시장조사/리서치에 매우 적합.

5. Extract (자연어 기반 정보 추출)

- 무엇을 할 수 있나?

“이 페이지에서 가격 정보만 추출해줘”, “테이블 형태로 인물 목록 정리해줘” 같은 자연어 요청으로 구조화된 정보를 바로 뽑아냄. - 유용한 이유

BeautifulSoup이나 XPath 같은 복잡한 코딩 없이도 AI가 원하는 데이터를 알아서 추출.

6. 고급 기능

- JS 렌더링 처리: Puppeteer 기반으로 동적 웹사이트도 문제 없이 처리

- PDF / 이미지 처리: 문서 내부 텍스트 인식 후 자동 변환

- 인터랙션 지원: 버튼 클릭, 스크롤 다운 등 사용자 액션을 시뮬레이션

실제 사용 시나리오 예시

| 용도 | 설명 |

| 뉴스 수집 | search + scrape 기능으로 특정 주제 뉴스 모아보기 |

| e커머스 가격 수집 | crawl + extract로 상품 목록에서 가격 자동 수집 |

| 블로그 학습 데이터 수집 | map으로 URL 수집 → scrape로 텍스트 정제 |

| 시장 경쟁사 분석 | search + extract로 경쟁사 소개 및 특징 수집 |

아래에 Firecrawl의 기능을 실제로 웹 스크래핑에 활용하는 전체 예제 세트를 정리해드리겠습니다. 각 기능별 설명 + Python 예제 코드 + 활용 시나리오 + LLM 학습용 파이프라인까지 포함했습니다.

✅ 1. 단일 페이지 스크래핑 (scrape)

설명

한 URL에서 콘텐츠를 추출해 Markdown, HTML, JSON, 스크린샷으로 변환합니다.

동적 페이지도 처리합니다.

Python 예제

활용

- 블로그 글 추출

- 특정 기사 전문 저장

- 코드 예제 포함된 문서 수집

✅ 2. 전체 사이트 크롤링 (crawl)

설명

사이트의 모든 하위 페이지를 자동 탐색해 콘텐츠 수집 (사이트맵 불필요)

Python 예제

활용

- 개발 문서 전체 수집

- 이커머스 상품 페이지 전체 긁기

- 기술 블로그 아카이빙

✅ 3. 전체 URL 수집 (map)

설명

입력한 도메인에서 접근 가능한 모든 페이지의 URL 리스트를 제공합니다.

Python 예제

활용

- 먼저 구조 파악 후 타겟 스크래핑

- 크롤링 범위 제한 목적

✅ 4. 웹 검색 + 추출 (search)

설명

키워드 기반으로 관련 웹페이지를 찾고, 그 내용을 자동으로 수집합니다.

Python 예제

활용

- 시장 조사

- 기술 동향 분석

- 논문 및 뉴스 자동 수집

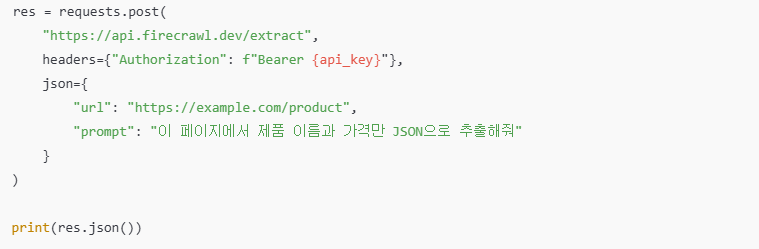

✅ 5. 자연어 추출 (extract)

설명

웹페이지에서 "가격만", "테이블만", "주소만" 등 원하는 정보만 추출합니다.

Python 예제

활용

- 비구조화 페이지에서 정보 정리

- 뉴스 헤드라인 + 요약만 추출

- 제품정보, 리뷰, 연락처 등 정리

✅ 고급 기능 활용 예시

| 기능 | 설명 |

| 동적 콘텐츠 | JavaScript 렌더링 페이지 대응 |

| 스크롤/클릭 | 스크롤 후 로딩되는 콘텐츠 수집 가능 |

| PDF/문서 처리 | PDF / DOCX 텍스트 자동 추출 |

| 이미지 인식 | 이미지 내 텍스트 OCR 추출 |

✅ LLM 학습용 데이터셋 구축 파이프라인

예시: 기술 블로그 → 데이터셋

✅ No-code / 연동 도구

| 플랫폼 | 연동 가능 여부 |

| LangChain | O |

| LlamaIndex | O |

| Flowise / Langflow | O |

| Zapier / Pabbly | O |

| Google Sheets 연동 | O (API 활용 시 자동화 가능) |

✅ 사용 시 유의사항

- 요금제: 500 크레딧 무료 (크롤 1회당 1~5 크레딧 소모)

- 속도 제한: 무료 계정은 속도 제한 있음

- 대량 스크래핑 시: 셀프호스팅 권장

이 글이 도움이 되었다면,아래 링크를 통해서 후원해주세요.( 맥주한잔 이나 커피한잔 )

'인공지능' 카테고리의 다른 글

| ChatGPT (OpenAI), Google Gemini, Meta AI, DeepSeek AI 비교 (0) | 2025.05.29 |

|---|---|

| BandLab,음악 제작, 협업, 마스터링, 배포까지 지원하는 올인원 플랫폼 (0) | 2025.05.24 |

| 이번 주(2025년 5월 셋째 주)의 인공지능(AI) 분야에서 주목할 만한 뉴스 (8) | 2025.05.24 |

| Google Veo 3,텍스트 ,이미지 기반으로 고품질 비디오를 생성 (0) | 2025.05.23 |

| 2025년 5월 3주차 최신 AI 뉴스 요약 (5) | 2025.05.16 |